Transforman señales cerebrales en habla a través de implantes y de IA

Investigadores de la Universidad de Radboud y la UMC Utrecht han logrado transformar las señales cerebrales en un discurso audible. Al decodificar las señales del cerebro a través de una combinación de implantes y IA, pudieron predecir las palabras que la gente quería decir con una precisión del 92 al 100%. Sus hallazgos se publican en el Journal of Neural Engineering este mes.

La investigación indica un desarrollo prometedor en el campo de las interfaces cerebro-computadora, según la autora principal Julia Berezutskaya, investigadora del Instituto de Conders para Cerebro, Cognición y Comportamiento de la Universidad de Radboud y UMC Utrecht.

La Dra. Berezutskaya y sus colegas de la UMC Utrecht y la Universidad de Radboud usaron implantes cerebrales en pacientes con epilepsia para inferir lo que la gente quiere expresar en palabras.

Trayendo voces

"Finalmente, esperamos poner esta tecnología a disposición de los pacientes en estado de bloqueo, que están paralizados e incapaces de comunicarse, " dijo la Dra. Berezutskaya. " Estas personas pierden la capacidad de mover los músculos y, por lo tanto, de hablar. Al desarrollar una interfaz cerebro-computadora, podemos analizar la actividad cerebral y darles una voz nuevamente. "

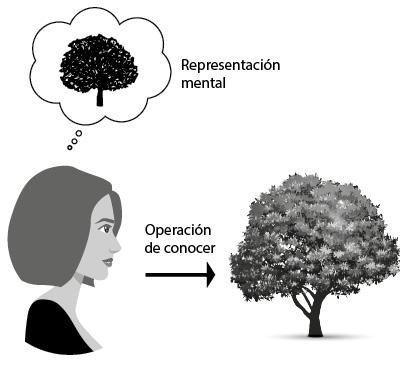

Para el experimento en este nuevo artículo, los investigadores pidieron a las personas no paralizadas con implantes cerebrales temporales que pronunciaran varias palabras en voz alta mientras se medía su actividad cerebral. Berezutskaya: ‘ Entonces pudimos establecer un mapeo directo entre la actividad cerebral, por un lado, y el habla, por otro lado. También utilizamos modelos avanzados de inteligencia artificial para traducir esa actividad cerebral directamente en un habla audible. Eso significa que no solo pudimos adivinar lo que la gente decía, sino que podríamos transformar de inmediato esas palabras en sonidos inteligibles y comprensibles. Además, el discurso reconstruido incluso sonaba como el orador original en su tono de voz y forma de hablar. ’

Investigadores de todo el mundo están trabajando en nuevos procedimientos para el reconocimiento de palabras y oraciones en patrones cerebrales. Los investigadores pudieron reconstruir el habla inteligible con conjuntos de datos relativamente pequeños, mostrando que sus modelos pueden descubrir el mapeo complejo entre la actividad cerebral y el habla con datos limitados.

En paralelo también realizaron pruebas de escucha con voluntarios para evaluar cuán identificables eran las palabras sintetizadas. Los resultados positivos de esas pruebas indican que la tecnología no solo está logrando identificar palabras correctamente, sino también transmitir esas palabras de manera audible y comprensible, al igual que una voz real.

Limitaciones

‘ Por ahora, todavía hay una serie de limitaciones, ’ advierte la Dra. Berezutskaya. " En estos experimentos, les pedimos a los participantes que dijeran doce palabras en voz alta, y esas fueron las palabras que intentamos detectar. En general, predecir palabras individuales es menos complicado que predecir oraciones completas. En el futuro, los modelos complejos de lenguaje que se utilizan en la investigación de IA pueden ser beneficiosos. Nuestro objetivo es predecir oraciones completas y párrafos de lo que las personas están tratando de decir basándose solo en su actividad cerebral. Para llegar allí, necesitaremos más experimentos, implantes más avanzados, conjuntos de datos más grandes y modelos de IA avanzados. Todos estos procesos aún tomarán varios años, pero parece que nos dirigimos en la dirección correcta. ’